云南省图书馆机构用户,欢迎您!

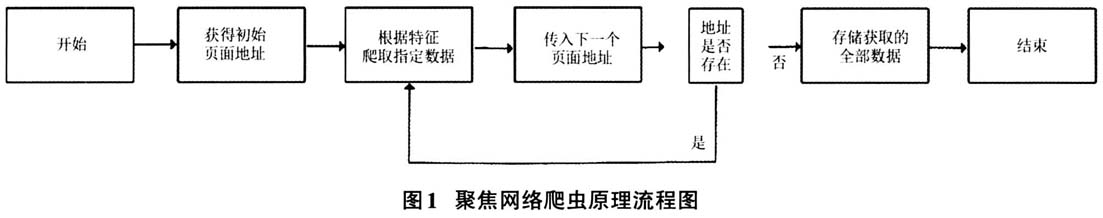

具体应用及实施路径 以获取北京市政府采购网(http://www.ccgp-beijing.gov.cn/)会议培训定点单位内容为例,通过详解聚焦网络爬虫实时爬取会议培训定点单位最新内容的原理和方法,以点带面提出解决事中审计难以获取结构化数据或数据获取不及时等问题的路径,不断推动审计关口前移,为未来深入开展事中审计监督奠定理论和实践基础。 (一)确定爬取策略 待爬取信息所在目标站点首页页面统一资源定位符(URL)地址为:http://114.255.53.119:82/MEETING_2009/mapsearch/findByTrainFlag.action?pageNo=1,打开站点后,可以直观地看到会议培训定点单位内容等相关信息,其中最需要关注的要素有两项,分别是位于页面顶端的统一资源定位符(URL)地址和页面中的会议培训定点单位具体信息。 由于会议培训定点单位信息内容较多,北京市政府采购网采用了常规的分页显示方法,即将众多单位的全部信息数据,按照每页只显示一定数量信息的方式,分散置入若干网页页面之中。 通过分析各会议培训定点单位信息页面,可以发现不同页面间的切换是通过统一资源定位符(URL)地址的最后一个传递参数pageNo进行切换的,即当定位参数pageNo=1时,URL地址指向的当前页面的显示结果,是全部会议培训定点单位信息中的第一页内容,以此类推,当定位参数pageNo为2、3、4等其他数值时,当前页面显示的内容为对应页面的会议培训定点单位信息。 由此,如果需要获取全部会议培训定点单位信息,仅需将定位参数pageNo作为一个变量传入爬虫程序,通过算数运算使定位参数pageNo每次自行增加1,即可自动获取下一页中会议培训定点单位的信息数据,直至最后一页,最终达成获取全部会议培训定点单位信息数据的目标。 (二)定位关键信息 使用谷歌等浏览器,进入开发者模式下的Network组件,通过相关功能可以记录会议培训定点单位信息网页从内部生成到对外显示的全过程,在记录到的各类网页要素中,排除图片(后缀为.jpg)、层叠样式表(后缀为.CSS)、动画图形交换文件(后缀为.gif)、页面脚本语言文件(后缀为.js)等具有明显特征的无关文件,迅速缩小筛查范围找到网页源代码文件,并查看源代码内容。使用源代码文件中的搜索功能,可以快速定位本次案例中需要获取的会议培训定点单位名称信息。 (三)爬取特定数据 通过搜索网页源代码可以发现,每家会议培训定点单位的名称,以“保利大厦有限公司”为例,在当前URL指定的页面中出现且仅出现了两次,需要提取的会议培训定点单位名称信息在网页其他信息的包裹之中,其中“保利大厦有限公司”第一次出现在〈input〉节点内,第二次出现是在〈a〉节点内。 第一次出现“保利大厦有限公司”的〈input〉节点只有一行代码,第二次出现“保利大厦有限公司”的〈a〉节点,则占据三行代码的位置,且其节点内的要素内容和格式样式更加多样,更容易被聚焦网络爬虫识别。举个例子,就如同在人海中,准确地找到一个穿黑衣服的人很难,但是定位一个身高170cm、体重80kg,穿黑色上衣、蓝色裤子,名字叫blank的人却相对容易一样。因此,笔者选取第二次出现“保利大厦有限公司”〈a〉节点,对其进行特征分析,编写与其特征相匹配的正则表达式:〈a\s.*?blank"〉/r\n\t\t\t\t\t\t\t\t\t\t\t\t\t(.*?)/r/n/t/t\t/t/t/t/t//t\t\t\t\t〈/a〉

具体应用及实施路径 以获取北京市政府采购网(http://www.ccgp-beijing.gov.cn/)会议培训定点单位内容为例,通过详解聚焦网络爬虫实时爬取会议培训定点单位最新内容的原理和方法,以点带面提出解决事中审计难以获取结构化数据或数据获取不及时等问题的路径,不断推动审计关口前移,为未来深入开展事中审计监督奠定理论和实践基础。 (一)确定爬取策略 待爬取信息所在目标站点首页页面统一资源定位符(URL)地址为:http://114.255.53.119:82/MEETING_2009/mapsearch/findByTrainFlag.action?pageNo=1,打开站点后,可以直观地看到会议培训定点单位内容等相关信息,其中最需要关注的要素有两项,分别是位于页面顶端的统一资源定位符(URL)地址和页面中的会议培训定点单位具体信息。 由于会议培训定点单位信息内容较多,北京市政府采购网采用了常规的分页显示方法,即将众多单位的全部信息数据,按照每页只显示一定数量信息的方式,分散置入若干网页页面之中。 通过分析各会议培训定点单位信息页面,可以发现不同页面间的切换是通过统一资源定位符(URL)地址的最后一个传递参数pageNo进行切换的,即当定位参数pageNo=1时,URL地址指向的当前页面的显示结果,是全部会议培训定点单位信息中的第一页内容,以此类推,当定位参数pageNo为2、3、4等其他数值时,当前页面显示的内容为对应页面的会议培训定点单位信息。 由此,如果需要获取全部会议培训定点单位信息,仅需将定位参数pageNo作为一个变量传入爬虫程序,通过算数运算使定位参数pageNo每次自行增加1,即可自动获取下一页中会议培训定点单位的信息数据,直至最后一页,最终达成获取全部会议培训定点单位信息数据的目标。 (二)定位关键信息 使用谷歌等浏览器,进入开发者模式下的Network组件,通过相关功能可以记录会议培训定点单位信息网页从内部生成到对外显示的全过程,在记录到的各类网页要素中,排除图片(后缀为.jpg)、层叠样式表(后缀为.CSS)、动画图形交换文件(后缀为.gif)、页面脚本语言文件(后缀为.js)等具有明显特征的无关文件,迅速缩小筛查范围找到网页源代码文件,并查看源代码内容。使用源代码文件中的搜索功能,可以快速定位本次案例中需要获取的会议培训定点单位名称信息。 (三)爬取特定数据 通过搜索网页源代码可以发现,每家会议培训定点单位的名称,以“保利大厦有限公司”为例,在当前URL指定的页面中出现且仅出现了两次,需要提取的会议培训定点单位名称信息在网页其他信息的包裹之中,其中“保利大厦有限公司”第一次出现在〈input〉节点内,第二次出现是在〈a〉节点内。 第一次出现“保利大厦有限公司”的〈input〉节点只有一行代码,第二次出现“保利大厦有限公司”的〈a〉节点,则占据三行代码的位置,且其节点内的要素内容和格式样式更加多样,更容易被聚焦网络爬虫识别。举个例子,就如同在人海中,准确地找到一个穿黑衣服的人很难,但是定位一个身高170cm、体重80kg,穿黑色上衣、蓝色裤子,名字叫blank的人却相对容易一样。因此,笔者选取第二次出现“保利大厦有限公司”〈a〉节点,对其进行特征分析,编写与其特征相匹配的正则表达式:〈a\s.*?blank"〉/r\n\t\t\t\t\t\t\t\t\t\t\t\t\t(.*?)/r/n/t/t\t/t/t/t/t//t\t\t\t\t〈/a〉